Des voitures qui voient loin

Des entreprises bretonnes cherchent à améliorer les « capacités visuelles » des voitures de demain.

Engagées dans la course aux véhicules autonomes, les entreprises bretonnes Autocruise et Edixia travaillent à améliorer respectivement les performances de détection des radars et des caméras tout en réduisant leur coût de production, les rendant ainsi accessibles aux véhicules d’entrée et de moyenne gammes.

Des radars dans les pare-chocs

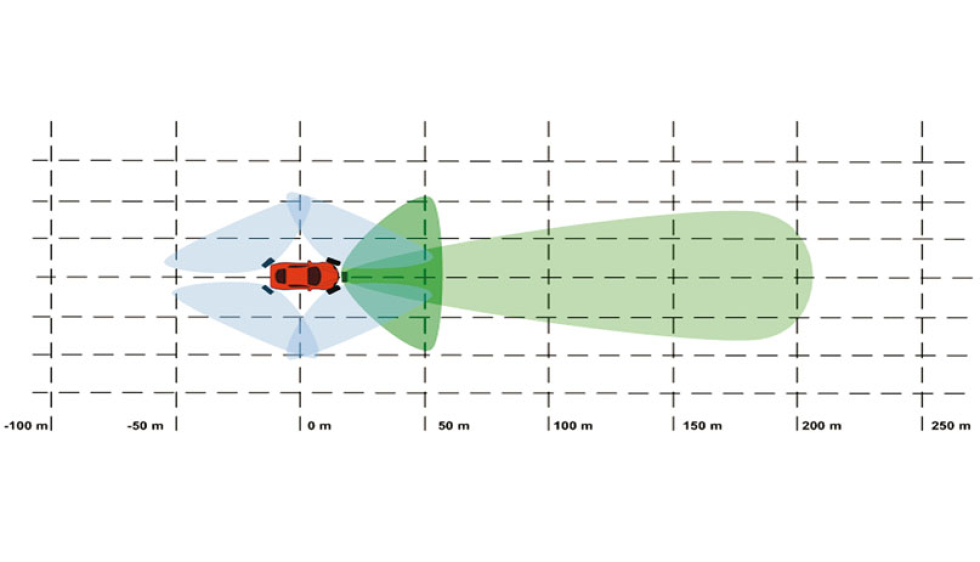

« D’ici à 2017, notre radar frontal AC1000 devrait équiper en série les nouvelles gammes d’un constructeur automobile généraliste », annonce Mickaël Léon, directeur de la société Autocruise basée près de Brest. Dernier-né des radars d’assistance à la conduite que cette filiale du groupe international TRW conçoit et fabrique, ce boîtier fixé à l’intérieur du pare-chocs avant des véhicules est capable de déclencher le freinage d’urgence et de réguler les distances entre véhicules. Comparé à ces prédécesseurs, ce radar a de multiples avantages. «1) Il bénéficie d’une meilleure précision de détection tout en étant trois fois plus petit, indique Mickaël Léon. Et ce grâce aux nouveaux matériaux semi-conducteurs (à base de silicium et germanium) que nous employons, mais aussi grâce à l’utilisation d’une bande de fréquence plus large. 2) Le champ de “vision” de l’AC1000 s’adapte automatiquement à la vitesse du véhicule. » Il peut ainsi balayer un angle allant de 20 ° sur une distance de 200 m sur autoroute, à 70 ° sur 100 m en ville. « De plus, il offre une nouvelle fonctionnalité qui permet en mode urbain (vitesse inférieure à 50 km/h) de différencier les piétons des véhicules et de déclencher si besoin le freinage d’urgence », ajoute Guillaume Bessière, responsable R&D d’Autocruise. Imaginons un piéton caché par une voiture stationnée ou un obstacle peu visible par mauvais temps (brouillard, neige...), l’AC1000 sera en mesure de localiser l’obstacle, d’analyser sa vitesse, sa trajectoire et de décider de freiner pour éviter toute collision. Le tout grâce à deux cartes électroniques : la première étant chargée de localiser tous les éléments de l’environnement du véhicule (rails de sécurité, autres véhicules...), la seconde de traiter en temps réel ces données et de décider ou non d’agir sur le véhicule. En cours de développement, le prochain radar devrait quant à lui jouir d’un champ de vision encore plus grand et savoir distinguer davantage d’objets (piétons, cyclistes, voitures…).

Un composant qui mime le cerveau

Comment traiter les soixante images que filme chaque seconde une caméra sans devoir équiper le véhicule d’un énorme processeur énergivore et coûteux ? Un casse-tête que la société Edixia (Vern-sur-Seiche, près de Rennes) cherchait à résoudre avant de découvrir, lors d’une journée sur le biomimétisme en 2014, un composant électronique capable d’analyser l’image comme le fait le cerveau humain. Mis au point par Patrick Pirim, fondateur de BVS Tech(1), celui-ci avait été pensé pour les besoins de la vidéosurveillance. À travers le projet Gwel(2) lancé en octobre dernier par Edixia et soutenu par l’Ademe, il est aujourd’hui en cours d’adaptation aux besoins d’assistance à la conduite. « À la différence d’un ordinateur qui traiterait ce type d’image pixel par pixel au moyen de milliers de lignes de codes, notre composant l’analyse selon le principe de vision perceptive, c’est-à-dire selon onze variables globales (luminance, teinte, saturation), structurales (gradients orientés, courbures, texture), dynamiques (écarts-temps, vitesse, direction) et spatiales (valeurs X et Y dans le champ de vision) », explique Gilles Wackenheim, dirigeant d’Edixia. Ainsi, pour que le composant identifie une voiture, par exemple, il suffit de lui fournir l’histogramme de cet objet, sa “signature graphique” en quelque sorte, pour chacune des onze variables. Il cherchera alors ces histogrammes, localisera ainsi l’objet recherché et suivra ses mouvements au fil des images en temps réel. « Cette technologie de reconnaissance de forme inspirée du biomimétisme permet ainsi de réduire en cascade les besoins de calcul, la taille du composant, la consommation d’énergie et les coûts inhérents au traitement d’images », souligne Gilles Wackenheim. Autre avantage de taille : ce composant peut aussi traiter les signaux d’autres capteurs (radars, infrarouges, sonores...). Et si les solutions d’avenir étaient déjà dans la nature ?

(1) Basée à Paris, BVS Tech (Brain Vision Systems) est une entreprise spécialisée dans la vision intelligente.

(2) Le projet Gwel a remporté le Trophée Innovation 2015 de la filière automobile.

Mickaël Léon et Guillaume Bessière

tél. 02 98 45 43 68

Gilles Wackenheim

tél. 02 99 62 86 11

info@edixia.fr

TOUT LE DOSSIER

du magazine Sciences Ouest