Faut-il mettre la recherche en pause ?

La révolution IA

La rapidité des progrès et les risques grandissants de mésusages de l’intelligence artificielle interrogent la responsabilité des développeurs et des utilisateurs.

Davantage de scientifiques impliqués, de données, de moyens… Depuis quelques années, le secteur de l’intelligence artificielle est en plein essor. « En 2020, les investissements cumulés des Gafam1 dans la recherche en IA atteignaient 125 milliards de dollars, soit l’équivalent du budget total de la recherche française », souligne Marion Trommenschlager, enseignante-chercheuse en sciences de l’information et de la communication à l’Université Rennes 2.

Demande de moratoire

Compte tenu des sommes incommensurables en jeu et des enjeux géopolitiques, notamment liés à la souveraineté des données, « de nombreux gouvernements orientent les financements de la recherche publique sur les sujets comme l’IA car ils craignent de se laisser distancer s’ils ne rentrent pas dans la course », analyse Élisa Fromont, chercheuse en informatique à l’Irisa2, à Rennes. Car oui, il s’agit bel et bien d’une course à l’innovation.

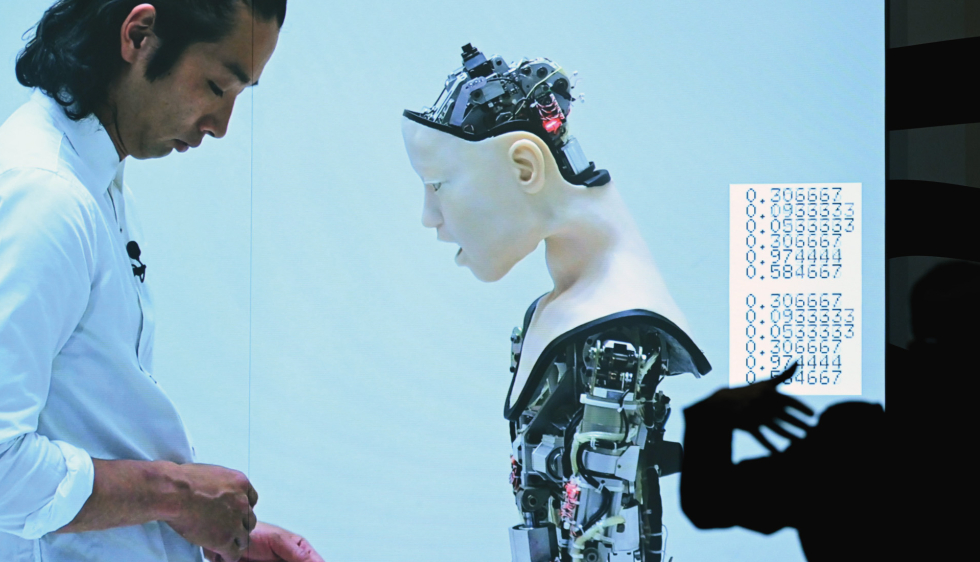

Face à cet emballement, en mars 2023, une lettre ouverte demandait à « tous les laboratoires d'intelligence artificielle d'interrompre immédiatement, pour une durée d'au moins six mois, la formation de systèmes d'intelligence artificielle plus puissants que le GPT-43 ». Le texte, signé par plus de 30 000 personnes dont des scientifiques et des dirigeants de grandes entreprises du numérique, proposait de prendre du « recul par rapport à la course dangereuse vers des modèles de boîte noire4 imprévisibles et toujours plus grands, dotés de capacités émergentes ».

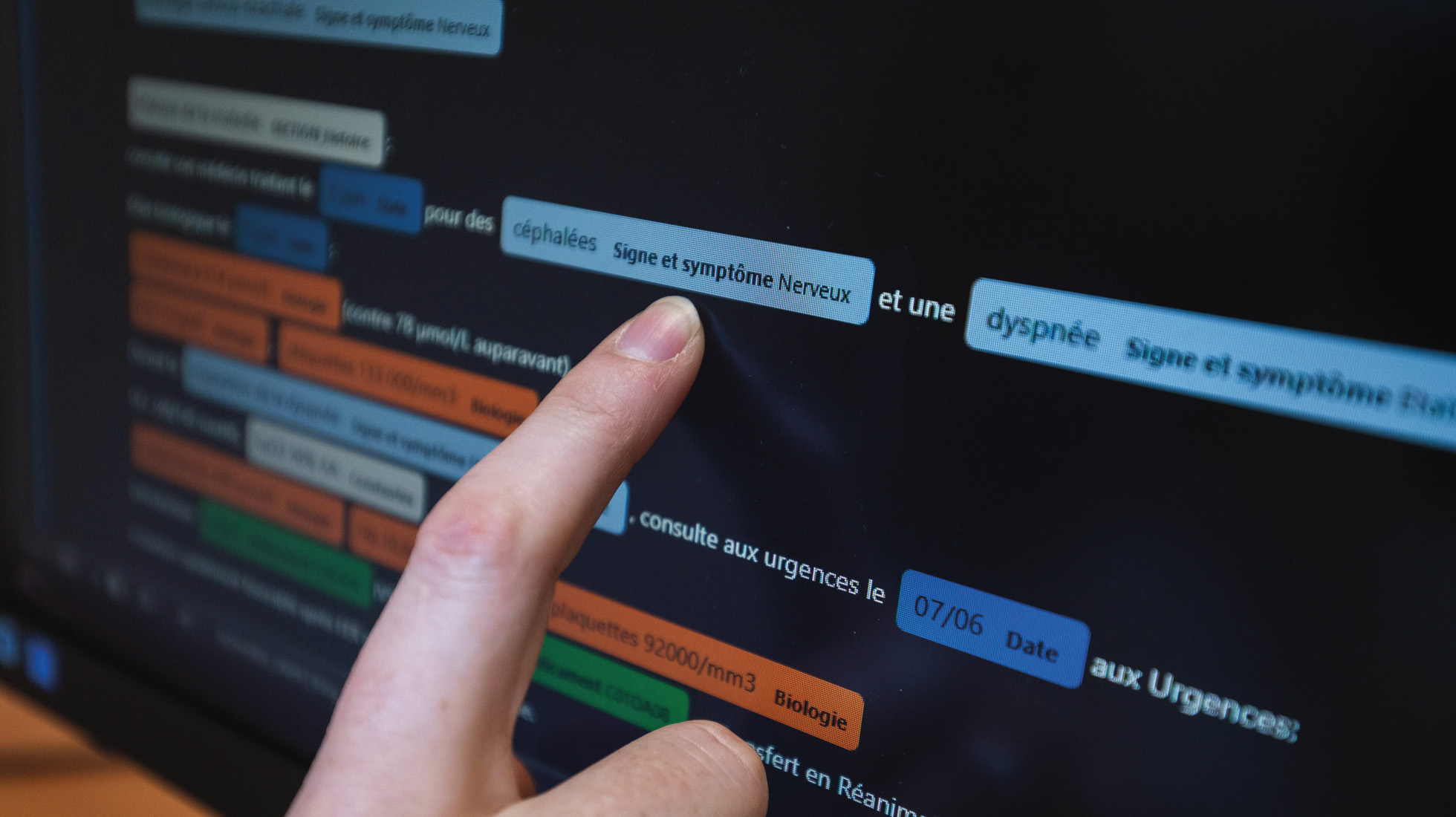

Des scientifiques ont développé une IA pour aider au diagnostic en cas de maladies rares. L'ordinateur recherche les similitudes entre le patient et un groupe de patients dans la base de données des hôpitaux de Paris (AP-HP).

Comprendre et s’armer

« Il est vrai que cela ferait du bien de se poser et de réfléchir », admet Élisa Fromont avant de souligner l’hypocrisie de certains signataires, comme Elon Musk, le PDG de Tesla, qui développait dans le même temps Grok, son propre agent conversationnel d’intelligence artificielle. Sur le papier, l’idée d’un moratoire est plutôt séduisante. En effet, plus rapides que la réglementation qui doit les encadrer, les avancées technologiques dans le domaine de l’IA inquiètent. Et plus que les dispositifs eux-mêmes, ce sont leurs usages qui interrogent. Particulièrement les mésusages : « L’IA n’est pas une sorte de magie mystique qu’il faut craindre, ce ne sont que des programmes informatiques, insiste Olivier Zhang, chercheur en informatique chez Orange Innovation, à Rennes. Par contre, s’en servir pour manipuler des informations ou détourner des contenus, oui, c’est problématique ».

Mais « n’oublions pas tous les bénéfices qu’on peut en tirer », relativise le chercheur. De plus en plus utilisée en médecine, l’intelligence artificielle facilite les diagnostics et fait gagner du temps aux médecins en réalisant des tâches chronophages et automatisables. « Elle devient aussi une aide précieuse aux mathématiciens pour construire des raisonnements », souligne Nicolas Courty, professeur d’informatique à l’UBS5, à Vannes, et responsable de l’équipe de recherche Obelix qui se sert de la technologie pour analyser des images satellites d’observation de la Terre. Plus globalement, l’IA réduit le taux d’erreurs humaines, améliore la productivité des entreprises et diminue les coûts de certains processus. D’un autre côté, « on se crée des usages dont on n'avait pas forcément besoin, le tout à un coût environnemental prohibitif », répond Élisa Fromont. Quoi qu’il en soit, pour la chercheuse, « il y a trop d’argent et d’acteurs en jeu pour que quiconque prenne le risque de rater le train ». Et « si on arrête la recherche, quelqu’un d’autre la fera. Il vaut mieux la poursuivre pour comprendre les modèles développés par les industriels en pointe et être armés afin de pouvoir faire face aux risques qu'ils posent », argue Olivier Zhang.

Orienter la recherche

Les systèmes d’IA qui inondent le marché aujourd’hui ont été nourris de milliards de données. Et consciemment ou pas, certains biais sont parfois introduits dans leur programmation : si des systèmes sont racistes ou sexistes, c’est parce qu’ils ont été configurés à partir de données racistes ou sexistes. « La technologie n’est pas neutre puisqu’il y a des gens qui la paramètrent dans un but défini, ce qui peut conduire à des orientations ou des renforcements des façons de penser », décrypte Marion Trommenschlager. Derrière, se tissent ainsi des risques liés à « l’infusion de certaines idéologies dans des médias numériques » massivement utilisés par la population. « C’est un enjeu lié à la préservation des démocraties », poursuit la chercheuse.

La mise au point de technologies si puissantes interroge la responsabilité de ceux qui les utilisent, mais aussi celle de leurs développeurs. Plutôt que de mettre un coup d’arrêt à la recherche, la solution pourrait plutôt être de l’orienter, par le biais de réglementations et de politiques publiques. En juillet 2024, l’Europe est devenue le premier territoire du monde à disposer d’une législation sur l’IA. Le texte, qui entrera pleinement en vigueur en août 2026, doit encadrer et interdire les applications de l’intelligence artificielle selon une approche fondée sur le risque. Un premier pas ?

1. Google, Apple, Facebook (Meta), Amazon et Microsoft.

2. Institut de recherche en informatique et systèmes aléatoires.

3. Modèle d’intelligence artificielle sur lequel repose aujourd'hui ChatGPT.

4. L’effet boîte noire fait référence à l’incompréhension des mécanismes à l’origine du résultat fourni par une IA.

5. Université Bretagne Sud.

TOUT LE DOSSIER

du magazine Sciences Ouest